Cómo correr DeepSeek R1 en Local

¿Quieres correr un potente modelo de lenguaje en tu propia computadora sin depender de la nube? En este post, te mostraremos paso a paso cómo instalar y configurar DeepSeek R1, un LLM gratuito y avanzado. Usaremos Docker, Ollama y Open Web UI para hacerlo fácil y accesible.

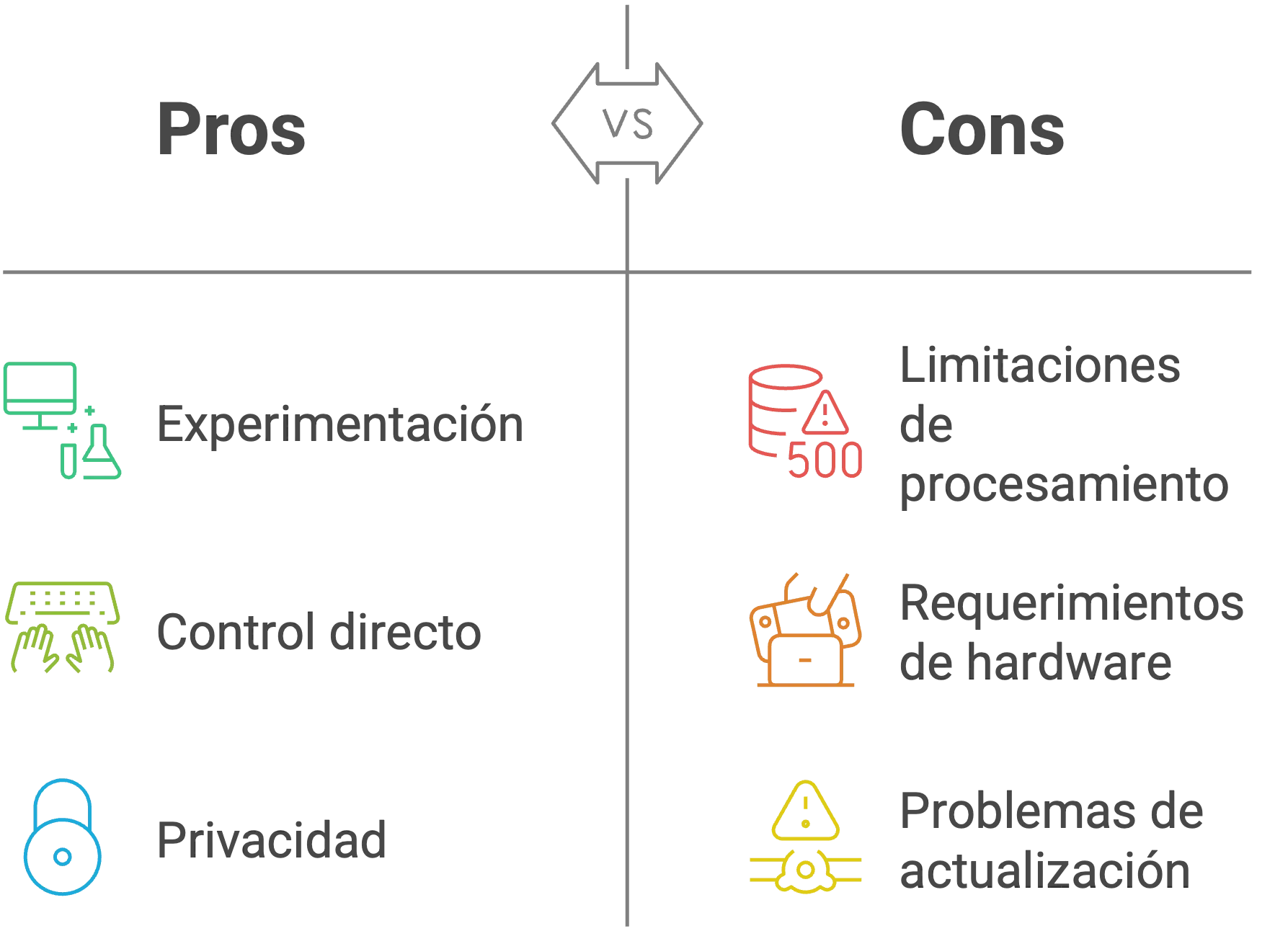

Es importante mencionar que existen algunas limitaciones al momento de correr modelos de lenguaje localmente. Correr un modelo en local es una buena opción para experimentación y control directo, pero debe realizarse con cuidado debido a las limitaciones de procesamiento, requerimientos de hardware y posibles problemas de actualización.

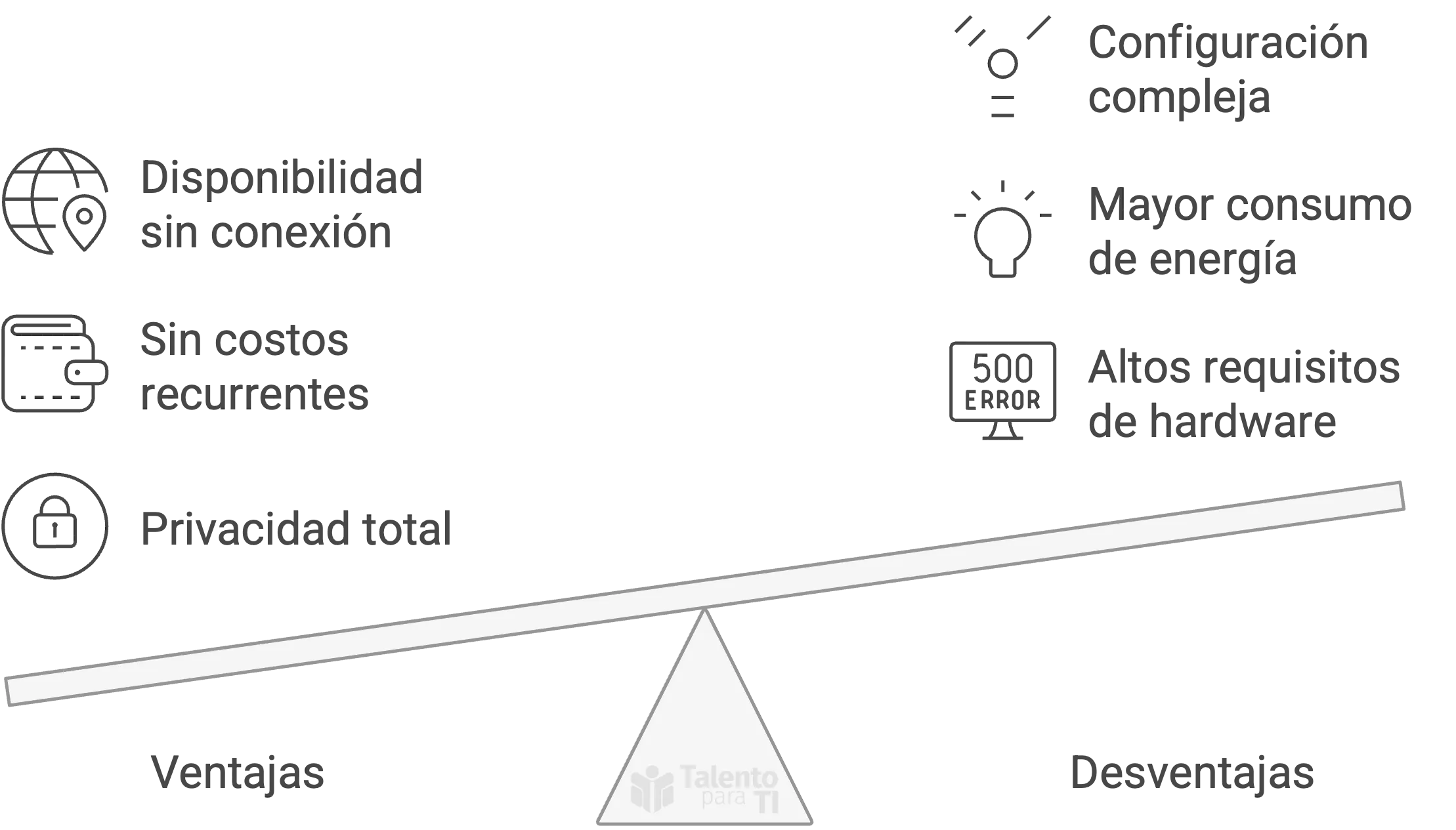

Ventajas y Desventajas

Correr modelos de lenguaje en local tiene sus ventajas y desventajas. Aquí te presentamos un resumen para que puedas tomar una decisión informada.

| Ventajas 🟢 | Desventajas 🔴 |

|---|---|

| Privacidad total: No necesitas enviar datos a la nube. | Altos requisitos de hardware: Puedes requerir una GPU potente y mucha RAM. |

| Sin costos recurrentes: No dependes de suscripciones ni pagos por API. | Mayor consumo de energía: Puede hacer que tu equipo consuma más recursos. |

| Disponibilidad sin conexión: Funciona sin depender de Internet. | Configuración compleja: Requiere instalación y ajustes manuales. |

| Control total: Puedes personalizar y optimizar el modelo según tus necesidades. | Actualizaciones manuales: No se actualiza automáticamente como sucede en la nube. |

| Menor latencia: Respuestas más rápidas sin depender de la conexión a Internet. | Almacenamiento y espacio: Los modelos pueden ocupar varios gigabytes (GB) de espacio en tu disco |

Prerequisitos

Antes de instalar DeepSeek R1, asegúrate de contar con lo siguiente:

- Hardware adecuado:

- Al menos 8 GB de RAM para modelos pequeños (hasta 7B parámetros).

- 16-32 GB de RAM para modelos más grandes (13B, 32B, 33B parámetros).

- Preferiblemente una GPU NVIDIA con al menos 8 GB de VRAM (recomendable 12-24 GB para modelos más grandes).

- Docker 🐳: Necesario para la virtualización y gestión de contenedores.

- Docker Desktop 🖥️: Requerido para ejecutar Docker fácilmente en Windows y macOS.

- Docker Compose ⚙️: Facilita la configuración y ejecución de múltiples contenedores.

- Git: Necesario para clonar el repositorio (si no lo tienes, descárgalo).

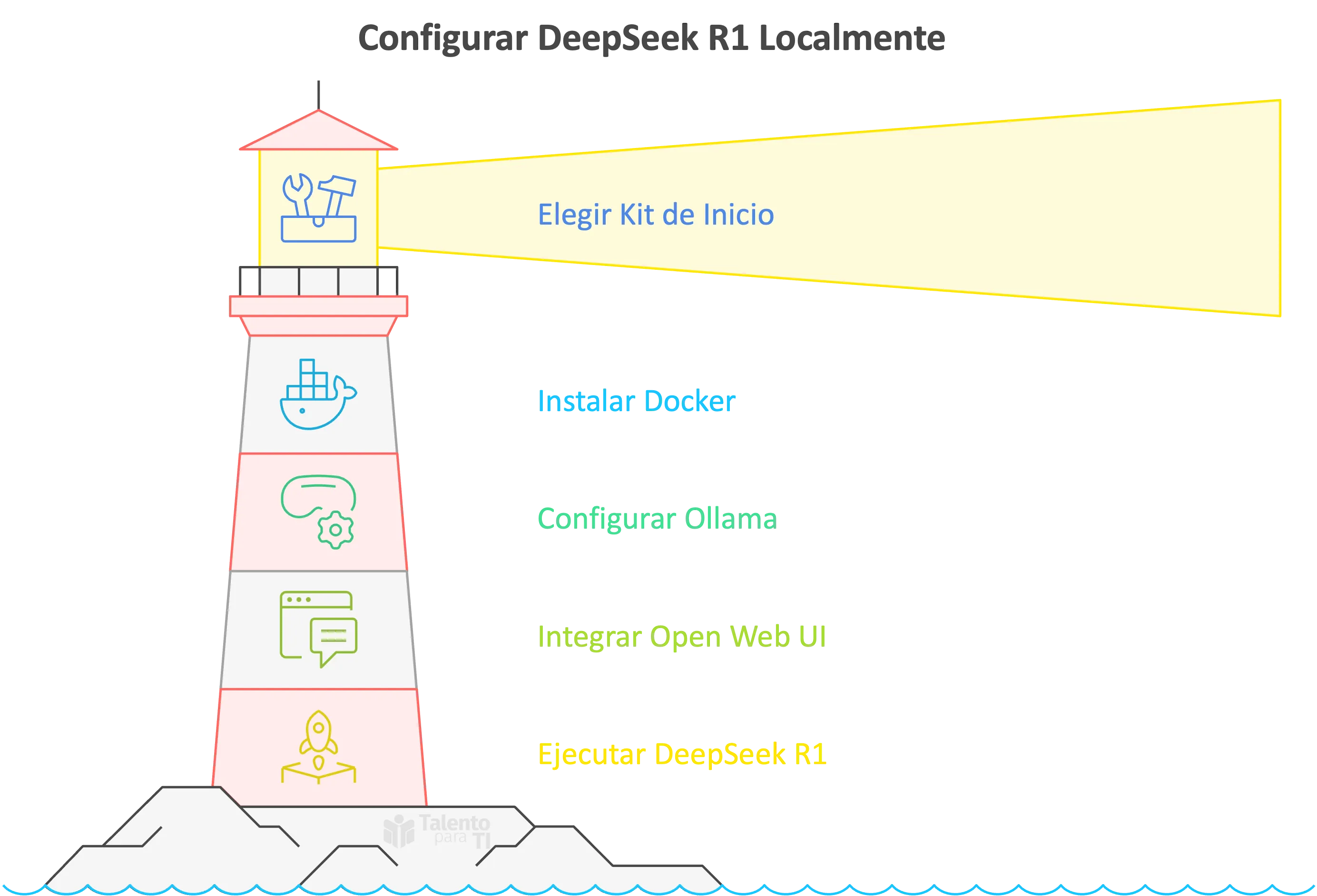

Instalación de DeepSeek R1

Esta guía detalla la instalación de DeepSeek R1 en tu sistema local utilizando Docker, Ollama y Open Web UI.

- Docker: Es una plataforma que permite empaquetar aplicaciones y sus dependencias en contenedores, asegurando que funcionen de manera consistente en cualquier entorno.

- Ollama: Es una herramienta que permite descargar, ejecutar y gestionar modelos de lenguaje grandes (LLMs) localmente.

- Open Web UI: Es una interfaz web amigable que facilita la interacción con los LLMs, similar a ChatGPT.

Docker simplifica la instalación, mientras que Ollama sirve los modelos de lenguaje y Open Web UI proporciona una interfaz de chat amigable.

1. Opciones de Instalación:

Existen dos kits de inicio que facilitan la instalación de las herramientas necesarias. Ambos kits incluyen componentes valiosos, pero la opción B ofrece una mejor configuracion que explicaremos más adelante.

2. Instalación (Opción B - Recomendada):

Como se mencionó anteriormente, recomendamos la Opción B por su conjunto de herramientas más completo, incluyendo Open Web UI, que usaremos en esta guía.

- Nvidia GPU

- Mac

- Otros

Para usuarios de Nvidia GPU

git clone https://github.com/coleam00/ai-agents-masterclass.git

cd ai-agents-masterclass/local-ai-packaged

# Modificar el archivo .env (ver paso 3)

docker compose --profile gpu-nvidia upPara usuarios de Mac / Apple Silicon

Si estás usando una Mac con un procesador M1 o más reciente, desafortunadamente no puedes exponer tu GPU a la instancia de Docker. En este caso, hay dos opciones:

- Ejecutar el kit de inicio completamente en la CPU, como en la sección “Para todos los demás” a continuación.

- Ejecutar Ollama en tu Mac para una inferencia más rápida, y conectarte a él desde la instancia de n8n.

Si deseas ejecutar Ollama en tu Mac, consulta la página de inicio de Ollama para obtener instrucciones de instalación, y ejecuta el kit de inicio de la siguiente manera:

git clone https://github.com/coleam00/ai-agents-masterclass.git

cd ai-agents-masterclass/local-ai-packaged

# Modificar el archivo .env (ver paso 3)

docker compose upDespués de seguir la configuración de inicio rápido a continuación, cambia las credenciales de Ollama usando http://host.docker.internal:11434 como el host.

Para todos los demás

git clone https://github.com/coleam00/ai-agents-masterclass.git

cd ai-agents-masterclass/local-ai-packaged

# Modificar el archivo .env (ver paso 3)

docker compose --profile cpu upPara usuarios de Nvidia GPU

git clone https://github.com/coleam00/ai-agents-masterclass.git

cd ai-agents-masterclass/local-ai-packaged

# Modificar el archivo .env (ver paso 3)

docker compose --profile gpu-nvidia upPara usuarios de Mac / Apple Silicon

Si estás usando una Mac con un procesador M1 o más reciente, desafortunadamente no puedes exponer tu GPU a la instancia de Docker. En este caso, hay dos opciones:

- Ejecutar el kit de inicio completamente en la CPU, como en la sección “Para todos los demás” a continuación.

- Ejecutar Ollama en tu Mac para una inferencia más rápida, y conectarte a él desde la instancia de n8n.

Si deseas ejecutar Ollama en tu Mac, consulta la página de inicio de Ollama para obtener instrucciones de instalación, y ejecuta el kit de inicio de la siguiente manera:

git clone https://github.com/coleam00/ai-agents-masterclass.git

cd ai-agents-masterclass/local-ai-packaged

# Modificar el archivo .env (ver paso 3)

docker compose upDespués de seguir la configuración de inicio rápido a continuación, cambia las credenciales de Ollama usando http://host.docker.internal:11434 como el host.

Para todos los demás

git clone https://github.com/coleam00/ai-agents-masterclass.git

cd ai-agents-masterclass/local-ai-packaged

# Modificar el archivo .env (ver paso 3)

docker compose --profile cpu up3. Configuración del archivo .env:

Después de clonar el repositorio, en la carpeta local-ai-packaged, encontrarás un archivo llamado .env.example.

- Copia este archivo y renómbralo a

.env(elimina el.example). - Abre el archivo

.envcon un editor de texto (se recomienda Visual Studio Code). - Este archivo contiene contraseñas para las herramientas, aunque no es necesario modificarlas para este tutorial, es importante conocer las credenciales por defecto para un uso futuro.

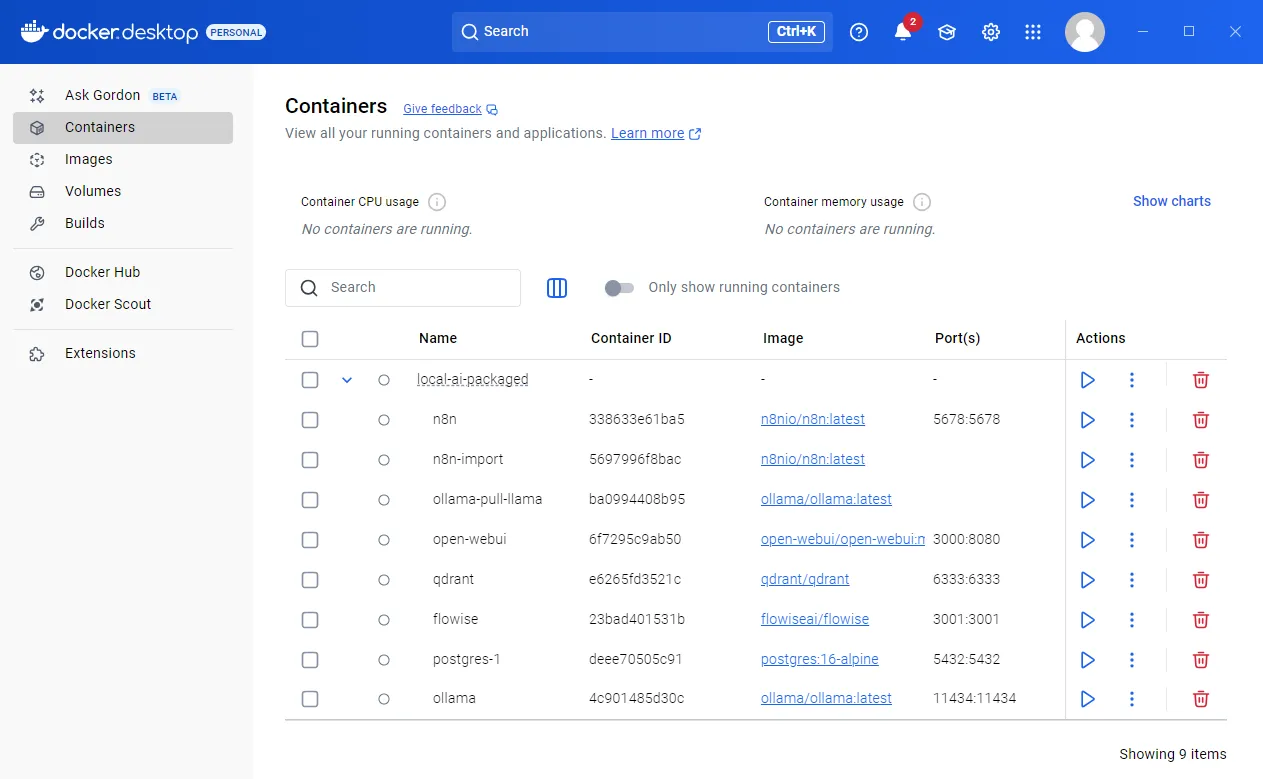

4. Verificación en Docker Desktop

- Abre Docker Desktop.

- Asegúrate que todos los contenedores e imágenes se hayan instalado correctamente.

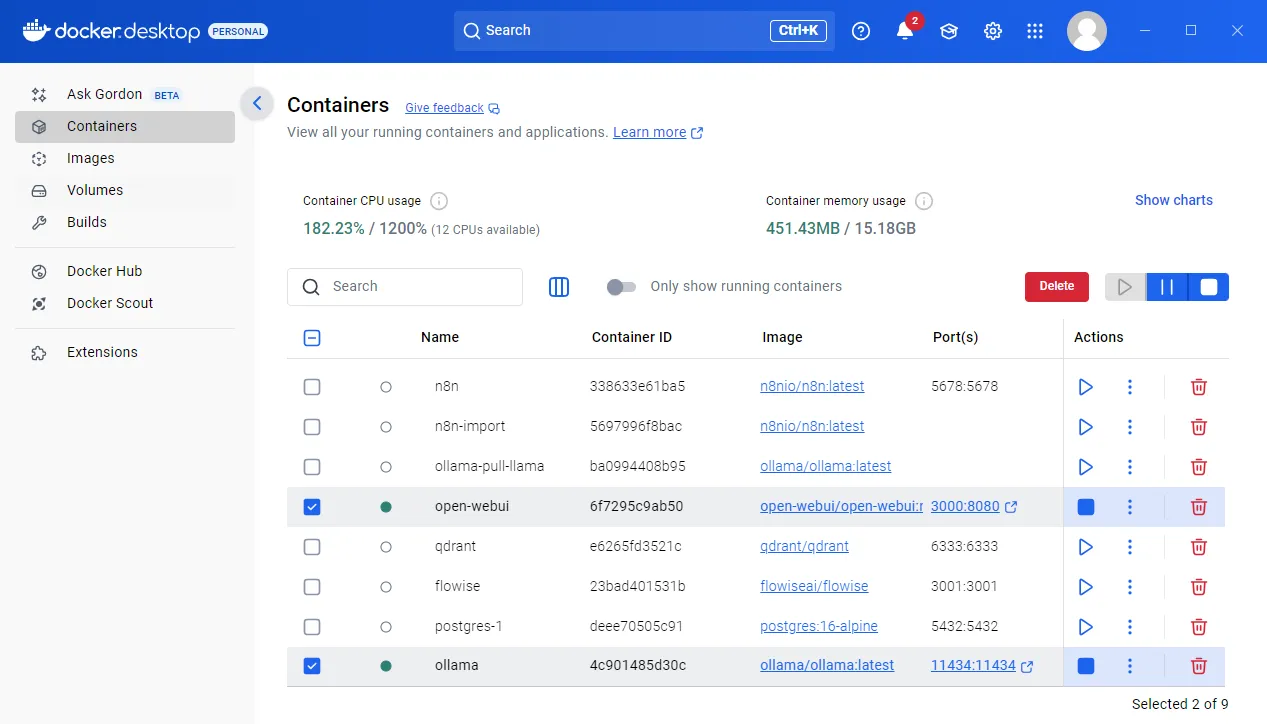

5. Ejecución de los Contenedores

- En Docker Desktop, verifica si todos los contenedores se están ejecutando.

- Si algún contenedor no se está ejecutando, inícialo manualmente.

- Asegúrate que los contenedores de

ollamayopen-webuiestén en ejecución.

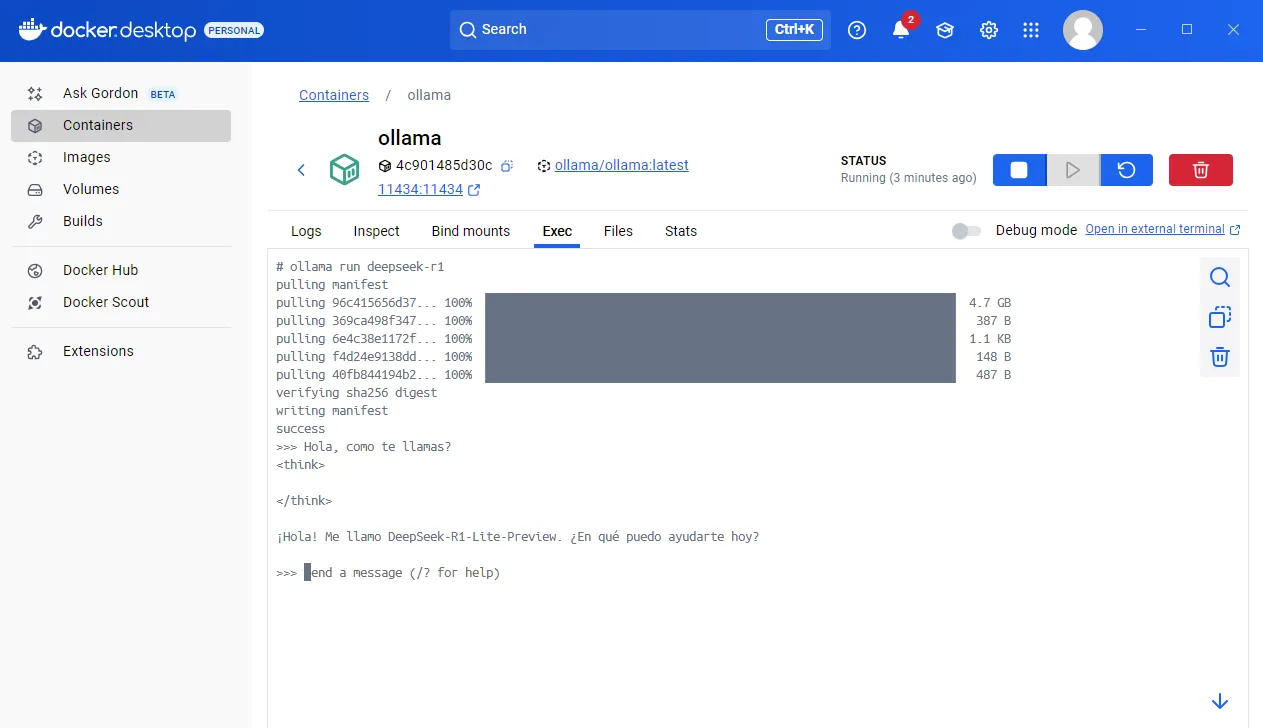

6. Instalación del Modelo DeepSeek R1

-

Puedes descargar este y otros modelos desde Ollama.

-

Para instalar DeepSeek R1, abre la terminal dentro del contenedor de Ollama en Docker Desktop:

- Docker Desktop > Contenedores / Containers > ollama > Ejecutar / Exec

-

Ejecuta el siguiente comando:

ollama run deepseek-r1

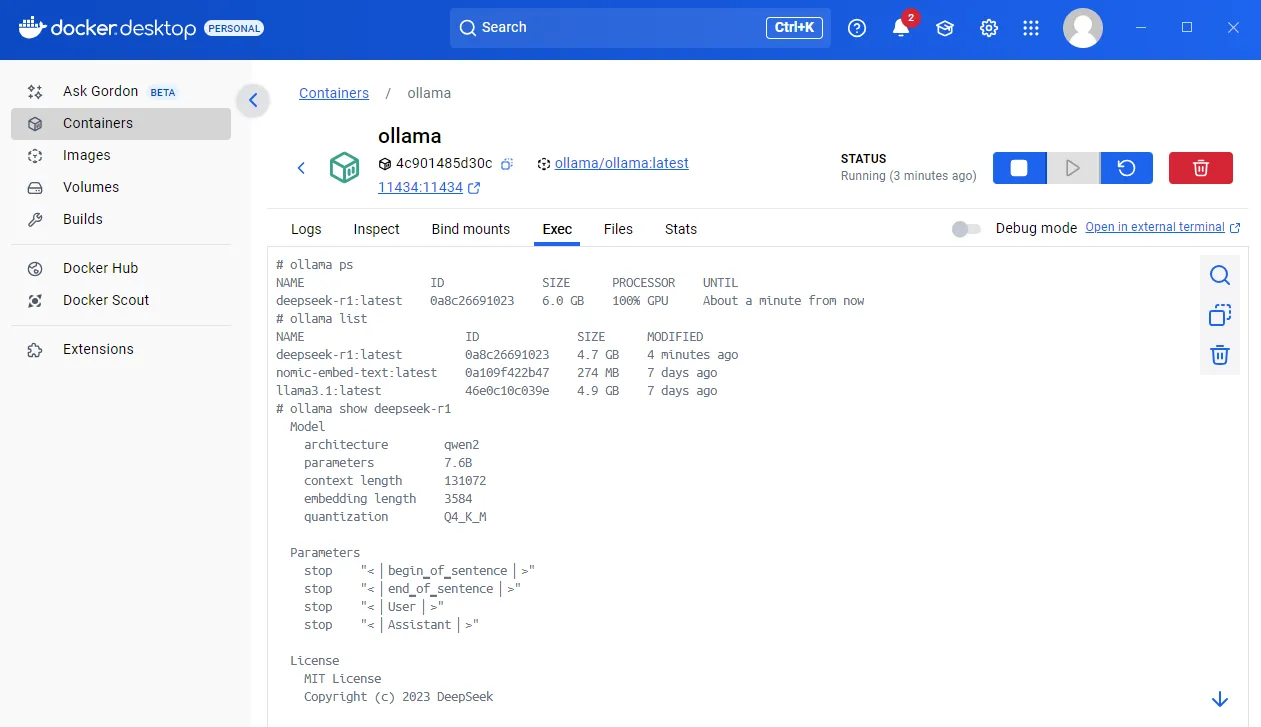

7. Comandos Útiles de Ollama

Una vez instalado el modelo, puedes usar los siguientes comandos en la terminal de Ollama para gestionarlo:

-

ollama psMuestra los modelos en ejecución. -

ollama listLista los modelos instalados. -

ollama show deepseek-r1Muestra información detallada sobre el modelo DeepSeek R1 (nombre, parámetros, etc.). (Reemplaza “deepseek-r1” con el nombre del modelo que quieras consultar)

8. Consideraciones Adicionales

- Los modelos de lenguaje comprimidos pueden tener limitaciones en comparación con los modelos completos.

- Para obtener mejores resultados, especialmente con modelos comprimidos, considera usar: prompts en inglés.