MLflow 3.0 para GenAI: Trazabilidad, Evaluación y Escalabilidad en una Sola Plataforma

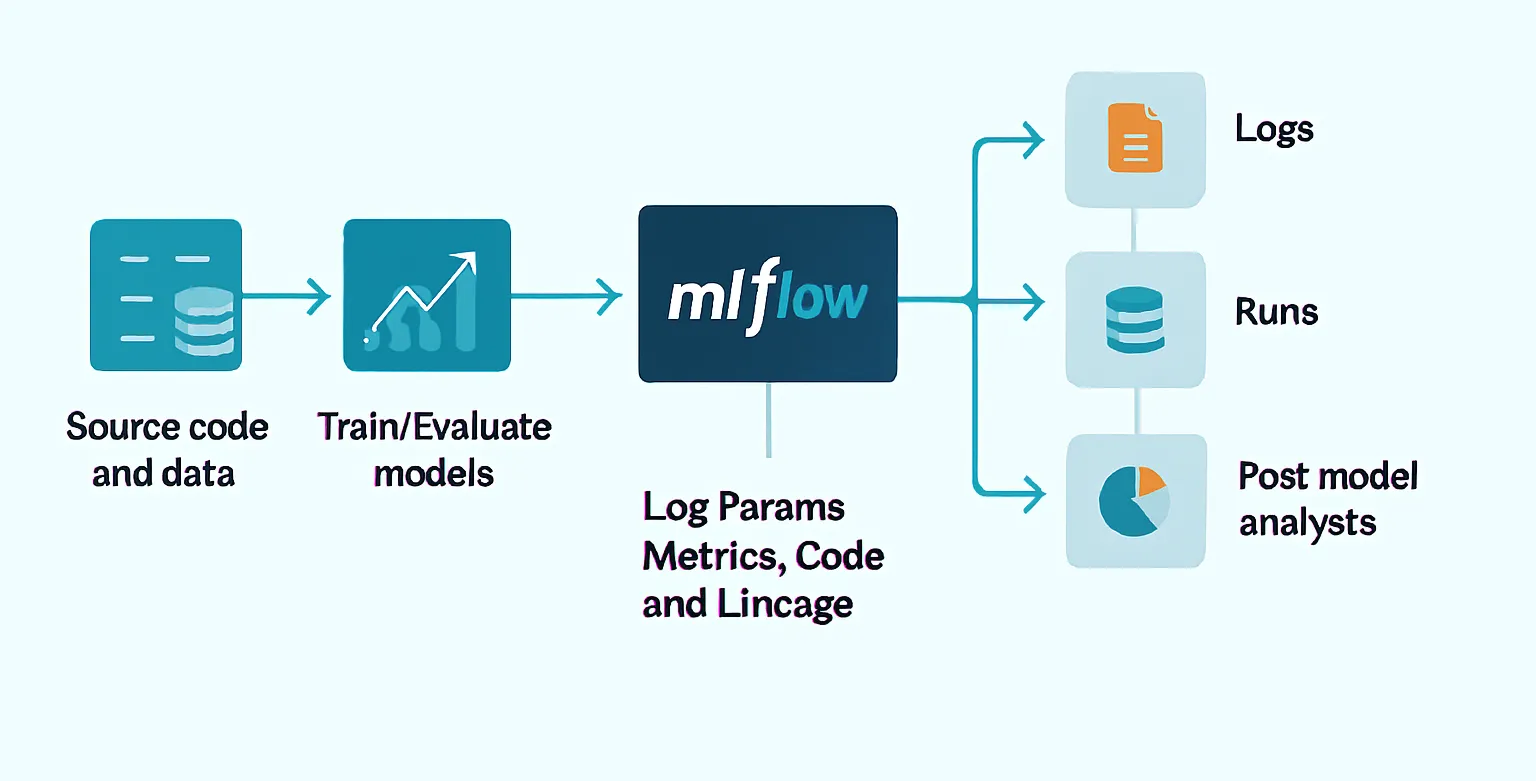

MLflow es una plataforma de código abierto creada para gestionar de principio a fin el ciclo de vida de los modelos de machine learning. Desde su lanzamiento en 2018, ha evolucionado hasta convertirse en un estándar en MLOps, ayudando a los equipos de ciencia de datos y aprendizaje automático a registrar experimentos, versionar modelos y desplegarlos de manera reproducible. Sin embargo, la llegada de la inteligencia artificial generativa (GenAI) ha cambiado las reglas del juego: ahora los sistemas no solo predicen, sino que generan texto, código y contenido, lo que introduce nuevos desafíos. Las organizaciones necesitan medir la calidad de las respuestas generadas, versionar prompts y modelos de manera consistente, auditar interacciones y garantizar el cumplimiento normativo, algo que los enfoques tradicionales de MLOps no cubren por completo.

MLflow 3.0 surge como la respuesta a estos retos. No es una simple actualización, sino una evolución que convierte a MLflow en un marco unificado para experimentación, observabilidad, evaluación de calidad y gobernanza de aplicaciones GenAI. Integrado de forma nativa en Databricks, esta versión proporciona trazabilidad completa de cada ejecución, métricas consistentes entre entornos y herramientas de evaluación automatizada que permiten detectar problemas de relevancia, corrección, seguridad o alucinaciones. Con MLflow 3.0, las organizaciones pueden pasar de prototipos aislados a soluciones de producción confiables, escalables y auditables, llevando GenAI al nivel de exigencia que demandan los entornos empresariales.

¿Qué es MLflow 3.0 para GenAI?

MLflow 3.0 es la última versión de la plataforma de código abierto para MLOps, optimizada para los desafíos únicos de GenAI. A diferencia de las versiones anteriores, MLflow 3.0 introduce:

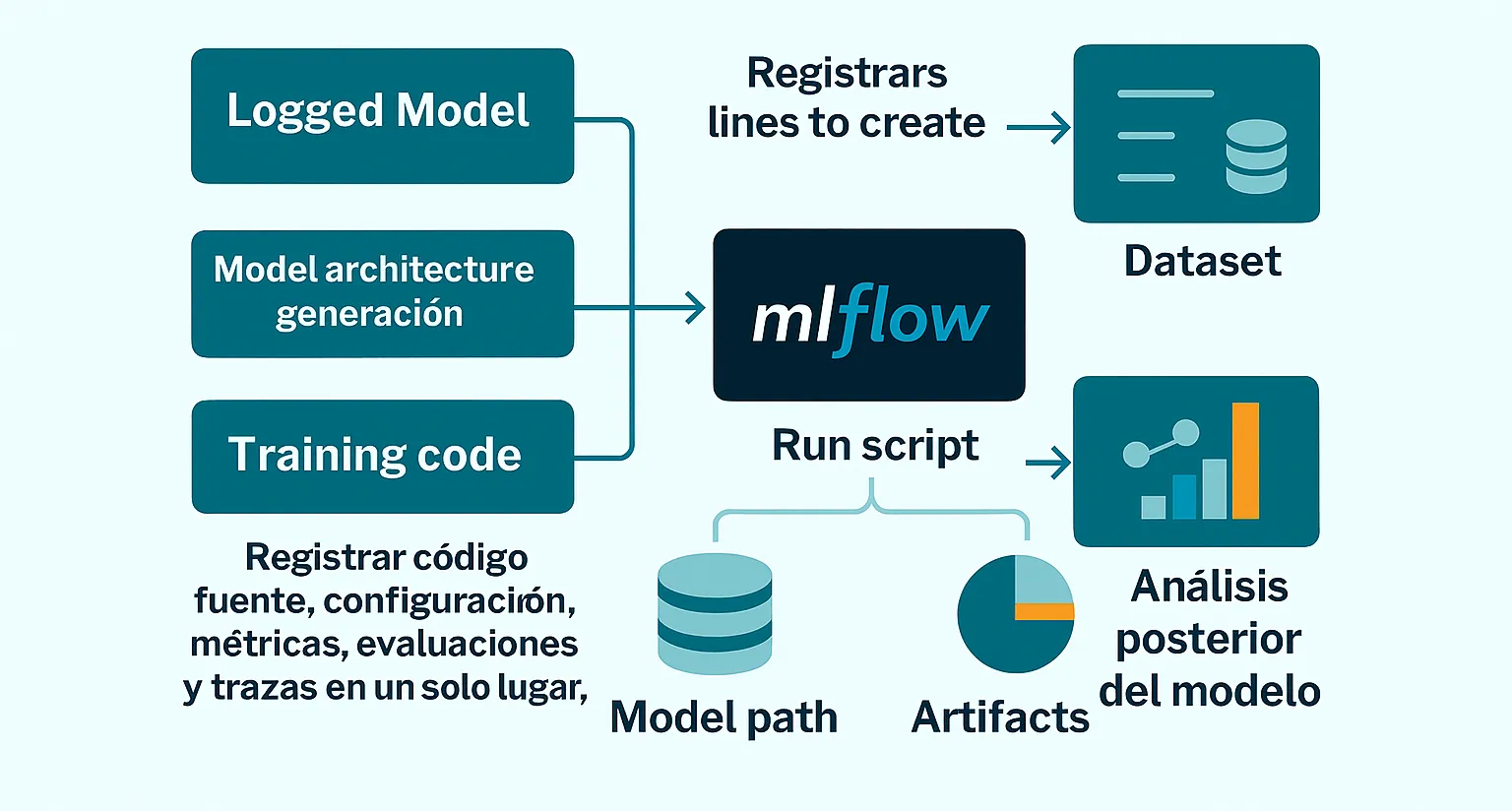

- LoggedModel: un nuevo concepto que vincula cada modelo con su código fuente (commits), configuración, métricas, evaluaciones y trazas.

- Observabilidad integral: seguimiento completo de prompts, respuestas, latencias, tokens y costos con una sola línea de código.

- Evaluación automatizada de calidad: calificadores integrados y personalizables para medir relevancia, corrección, seguridad y alucinaciones.

- Gobernanza empresarial: control de versiones, integración con Unity Catalog y cumplimiento normativo.

Ventajas Clave

| Ventaja | Descripción |

|---|---|

| Plataforma unificada | Desde el desarrollo hasta la supervisión en producción, todo ocurre en un mismo lugar. |

| Flexibilidad total | Compatible con cualquier LLM y frameworks como OpenAI, LangChain, LlamaIndex, DSPy y Anthropic. |

| Métricas consistentes | Lo que se mide en desarrollo se sigue midiendo en producción, garantizando comparabilidad. |

| Feedback humano integrado | Convierte interacciones reales en casos de prueba para mejorar el modelo. |

| Registro y versionado de prompts | Prueba, compara y optimiza prompts de manera sistemática. |

| Seguridad y cumplimiento | Gobernanza unificada con Databricks Unity Catalog, control de accesos y auditoría. |

Demostración de Trazabilidad Automática en MLflow 3.0

Un flujo típico con MLflow 3.0 no requiere reescribir tu aplicación. Solo debes activar la trazabilidad automática antes de ejecutar tu código:

import mlflow

mlflow.autolog() # Activa trazabilidad automática

# Tu código GenAI se mantiene igual

response = client.chat.completions.create(

model="gpt-4",

messages=[{"role": "user", "content": "Resume el reporte trimestral."}]

)

print(response.choices[0].message)Lo importante aquí es lo que ocurre detrás de escena: con mlflow.autolog(), cada interacción con el modelo se registra de manera centralizada. Esto incluye el prompt original, el número de tokens utilizados, la latencia de la respuesta y el costo estimado de la operación. Gracias a esto, no necesitas escribir código adicional para capturar métricas ni crear manualmente tablas de seguimiento. Posteriormente, en Databricks o en tu instancia de MLflow, puedes visualizar todas las trazas, filtrar por experimentos, comparar resultados y detectar oportunidades de optimización (por ejemplo, prompts demasiado largos o modelos con mayor costo por token).

Evaluación Automatizada de Aplicaciones GenAI

La evaluación de calidad es uno de los pilares de MLflow 3. Esta versión introduce un sistema de evaluación integral que permite medir de manera objetiva, reproducible y continua el desempeño de aplicaciones GenAI en cualquier entorno.

Detección de contenido inseguro.

Alucinaciones

Mide fidelidad de la respuesta.

Relevancia y corrección

Verifica utilidad y precisión.

Jueces personalizados

Adapta la evaluación a tus necesidades de negocio.

info

Esto reemplaza pruebas manuales costosas por evaluaciones reproducibles y consistentes.

Migración y Consideraciones Técnicas

MLflow 3.0 no es solo una actualización: es una nueva forma de trabajar con modelos GenAI. El concepto de LoggedModel centraliza todo —código, configuración, métricas, evaluaciones y trazas— en un solo lugar, facilitando auditoría y reproducibilidad.

Además, con mlflow.autolog(), se registra automáticamente información clave como prompts, respuestas, latencias y costos, tanto en desarrollo como en producción. Esto simplifica la instrumentación y mejora la comparabilidad entre entornos.

El diagrama muestra cómo estos componentes se integran en un flujo más estructurado, conectando código, datos y análisis posterior del modelo.

Casos de Uso Destacados

Optimización continua de agentes conversacionales

Monitorea prompts y respuestas en producción para ajustar y mejorar el rendimiento de chatbots de forma iterativa.

Cumplimiento normativo y auditoría

Versiona modelos, métricas y trazas para cumplir regulaciones (HIPAA, ISO) y facilitar auditorías.

Detección de degradación en producción

Identifica caídas de rendimiento y calidad de respuestas, permitiendo reentrenar antes de impactar al negocio.

Entrenamiento con feedback humano

Convierte interacciones reales en casos de prueba y datos de entrenamiento para mejorar continuamente.

Conclusión

MLflow 3.0 redefine cómo se gestionan las aplicaciones GenAI en entornos profesionales. Al integrar trazabilidad completa, evaluación automatizada y control de versiones, ofrece una base sólida para escalar con confianza, auditar con precisión y mejorar continuamente.

Adoptarlo no es solo una decisión técnica: es una apuesta estratégica por la calidad, la seguridad y la sostenibilidad operativa en todo el ciclo de vida de tus modelos generativos.

Recursos

note

¿Te interesa aprender más y potenciar tus proyectos GenAI? Consulta la documentación oficial, el blog de Databricks y el repositorio de GitHub para descubrir todo lo que MLflow 3.0 puede ofrecerte.